![]()

1 Technologieinnovationen und die Folgen

1.1 Die neuen Spielregeln der Netzwerkökonomie

1.1.1 Der Netzwerkeffekt

Wie hat sich wohl der erste Besitzer eines Faxgerätes gefühlt?

Besitzerstolz über die exklusive Erwerbung, wie man sie etwa beim ersten Eigentümer eines neuen Sportwagens aus deutscher oder italienischer Produktion voraussetzen kann? Wohl kaum.

Unter dem Stichwort Netzeffekt oder Netzwerkeffekt erschließt sich ein Phänomen, das prägend ist für die vernetzte Gesellschaft: Der Nutzen eines Gutes oder Services steigt mit der Anzahl der anderen Verwender an. Je mehr Personen etwa einen Telefonanschluss haben und daher darü-ber für einen Teilnehmer erreichbar sind, umso wertvoller ist der Zugang zu dieser Struktur. Dies gilt natürlich auch für das eingangs beschriebene Faxgerät oder etwa den E-Mail-Dienst – beides sind etablierte Dienste, deren Einsatz im Business längst nicht mehr wie in den Anfangstagen von der Frage begleitet wird, ob es sich aufgrund der möglichen Reichweite eventuell lohnt, sondern durch die erdrückende Reichweite eher noch zu einem Zwang für die noch nicht Dienstnutzer wird, sich anzuschließen.

Betrachtet man das, was in der Fachwelt mit Netzwerkeffekt bezeichnet wird, näher, so lassen sich darunter folgende Zusammenhänge subsumieren: das Gesetz von Sarnoff einerseits, das Gesetz von Metcalfe und das Gesetz von Reed andererseits.

Das Gesetz von Sarnoff – benannt nach David Sarnoff, einem früheren Vorstand des amerikanischen Unternehmens RCA – bezieht sich auf Übertragungsnetzwerke, wie sie bei TV und Rundfunk vorkommen, so genannten Broadcast-Netzwerken. Bei dieser Form der Kommunikationsbeziehung steht ein Anbieter mit einer Vielzahl von Abnehmern in einer Beziehung (1:N). Das Gesetz von Sarnow besagt nun, dass der Wert des Netzes proportional zu der Anzahl der Nutzer zunimmt. Dies gilt – bei einer 1:N Beziehung natürlich auch im Internet, etwa bei dem Wert, der einer Werbefläche zuerkannt werden kann. Ausgeklammert bleibt die Frage, was an den Netzwerkrändern passiert, etwa wenn ein einzelner Nutzer oder Kunde „Offline” – d.h. jenseits der Reichweite des Netzwerkes – als Multiplikator eines Dienstangebotes wirkt.

Nach dem als Erfinder des Ethernet-Standards geltenden Bob Metcalfe ist das Metcalfesche Gesetz benannt. Metcalfe geht in seiner Betrachtung von einer direkten Beziehung zwischen beliebigen Nutzern aus, d.h. im Unterschied zu Sarnoff kommuniziert in diesem Modell jeder Teilnehmer eines Netzes mit jedem anderen 1:1. Es entsteht eine Beziehung zwischen gleichen, so genannten Peers. Damit sind N*(N-1) bidirektionale Verbindungen möglich. Beispiele für derartige Kommunikationsstrukturen wären das Postnetz, das Telefonnetz und der E-Mail-Verkehr. Der Wert eines solchen Netzes steigt entsprechend mit der Teilnehmerzahl im Quadrat an.

Mit Metcalfe kann auch das Phänomen der kritischen Masse erklärt werden. Hat ein solches Netzwerk einmal eine bestimmte kritische Größe erreicht, dann wird es damit quasi unwiderstehlich für andere und zieht weiteres Wachstum nach sich. Das bedeutet auch, dass etwa der zweite Anbieter eines inkompatiblen Netzes gegenüber einem ersten bereits erstarkten Netz kaum noch eine Chance hat, da ein neuer Nutzer – wenn er die Wahl hat – praktisch immer zu dem erheblich nutzenstärkeren Netz tendieren wird. Damit ist auch erklärt, warum es nur ein E-Mail-System gibt – und das trotz der Nachteile durch fehlende Authentifizierung und der Flut unerwünschter Werbebotschaften (SPAM).

Erweitert man nun das Metcalfesche Gesetz um einen Effekt, der durch die Bildung von Gruppen hervorgerufen wird, so erhält man das so genannte Gesetz von Reed. David P. Reed ist Professor am MIT Media Lab und gilt als Erfinder des UDP-Protokolls. Gruppen oder Communities entstehen autonom aus Personen mit gleichen Interessen, können aber auch von Unternehmen eingerichtet werden, um mit Lieferanten oder Kunden zu kommunizieren oder um etwa gemeinsam neue Produkte oder Dienste zu entwickeln.

Aufgrund der Gruppeneffekte wächst nach diesem Gesetz der Wert des Netzes exponentiell. Hintergrund ist die Beobachtung, dass es Möglichkeiten für 2N*(N-1) Gruppen innerhalb einer Netzstruktur aus N Teilnehmern gibt.

Dieses so genannte Gesetz von Reed wurde zuerst zitiert in: „The Law of the Pack”, Harvard Business Review (February 2001) pp 23–4.

Damit scheint das Thema Netzwerkeffekte aber noch nicht vollständig geklärt. Zu diskutieren wäre etwa die Frage, ob einzelne Verbindungen stets die gleiche Wertigkeit besitzen (wie etwa von Metcalfe angenommen) beziehungsweise – geht man von unterschiedlicher Wertigkeit aus – auf welchem Wege eine Bewertung der einzelnen Verbindungen vorgenommen werden könnte. Ungeachtet der hier noch offenen Fragen gilt:

Alle Betrachtungsweisen oder Gesetzmäßigkeiten zum Netzwerkeffekt haben einen zentralen Zusammenhang gemeinsam: der Wert eines Netzwerks hängt nach diesen Regeln von der Zahl der Teilnehmer ab. Während Sarnoff mit seinem broadcastorientierten Konzept auf Content fokussiert und Metcalfe die 1:1 Kommunikation bewertet, setzt Reed auf die Community-Effekte, die sich innerhalb einer Infrastruktur ergeben können, und gilt damit als einer der Wegbereiter der Konzepte rund um soziale Netzwerke, die gerne auch unter dem Schlagwort Web2.0 gefasst werden.

Betrachtet man die Geschichte des Internets, so lassen sich Belege für eine zeitweise Dominanz aller drei Gesetzmäßigkeiten finden.

In einer frühen Phase war das Internet eher ein Werkzeug für den Zugriff auf einzelne Ressourcen (etwa durch Zugriff auf Rechner in Forschungseinrichtungen), während zunehmend der Austausch von Informationen (etwa durch E-Mail) an Bedeutung gewann. In der aktuellen Phase ist zumindest die öffentliche Diskussion (Stichwort: Social Networks und Web2.0) bereits dominiert von Gruppeneffekten, von denen Privatnutzer wie Unternehmen gleichermaßen profitieren können.

Besonders innerhalb von Unternehmensnetzen lässt sich die Wirksamkeit der geschilderten Effekte belegen. Besonders stark wissensorientierte Unternehmen, wie etwa größere Unternehmensberatungsgesellschaften und alle sehr großen Organisationen profitieren überproportional davon. Das in einem solchen Unternehmen vorhandene Wissen erreicht jeden Mitarbeiter. Unnötige Doppelarbeiten werden vermieden, da – etwa in einem global agierendem Großunternehmen – das vorhandene Wissen jeden Mitarbeiter erreicht.

1.1.2 Grenzen der Netzwerkdiskussion: Gleichheit als Illusion

Hinterfragt man diese Gruppen aber genauer, so stellt man fest: Gleichheit ist eine Illusion, zumindest wenn es um die Beteiligung an Communities geht. Wenn Sie ein Online-Diskussionsforum besuchen und dieses eine Anzeige über die Zahl der Nutzer, die gerade „online” sind, enthält, ist Ihnen das vermutlich bereits aufgefallen: Die Anzahl der Besucher der Plattform ist meistens signifikant höher als die Zahl der Beitragenden in den Diskussionen. Dies gilt in unternehmensinternen Foren im Intranet großer Unternehmen gleichermaßen wie in Interessengruppen im privaten Umfeld im öffentlichen Internet. Jakob Nielsen benennt auf seiner Website zum Thema „Participation Inequality” (http://www.useitcom/alertbox/participation_inequality.html) einige wichtige Fakten:

• 90 Prozent der User einer solchen Seite verhalten sich rein passiv, sind so genannte „Lurker”, d.h. sie besuchen die Seite und lesen die Beiträge, aber liefern keinerlei eigene Beiträge oder Kommentare.

• 9 Prozent der Nutzer lesen überwiegend und liefern gelegentlich eigene Beiträge.

• 1 Prozent der Besucher partizipieren tatsächlich intensiv und liefern gleichzeitig den Großteil aller Beiträge.

Die Verteilung der Beiträge auf die User folgt demnach einer so genannten Zipf-Verteilung. Nach George Kingsley Zipf ist das so genannte Zipfsche Gesetz (von ihm in den 1930er Jahren entdeckt) ein Modell, mit dem man bei bestimmten Größen, die in eine Rangfolge überführt werden, deren Wert aus dem eigenen Rang der Größe abschätzen kann. Diesem wiederum liegt die bekannte Pareto-Verteilung zugrunde. Das Pareto-Prinzip – als „80-zu-20 Regel” in der Wirtschaft gut bekannt – findet sich auch hier als Grundlage wieder.

Diese von Nielsen beobachteten Effekte bei Web-Communities lassen sich auch rückblickend in Vorläufermedien wiederfinden.

In einer frühen Studie von Whittaker (Quelle: Steve Whittaker, Loren Terveen, Will Hill, and Lynn Cherny (1998): „The dynamics of mass interaction,” Proceedings of CSCW 98, the ACM Conference on Computer-Supported Cooperative Work (Seattle, WA, November 14–18, 1998), S. 257–264), der über 2 Millionen ausgewertete Usenet-Nachrichten zugrunde liegen, kommt er zu ähnlichen Ergebnissen für diese Urform der Online-Community.

Auch wenn Usenet- Newsgroups auch innerhalb von Unternehmen inzwischen häufig durch reine Webforen abgelöst wurden, ist die von Whittaker gemachte Analyse interessant, weil sich lediglich das Medium, aber nicht die Rahmenbedingungen einer Beteiligung geändert haben und die große Zahl der untersuchten Nachrichten weitergehende Rückschlüsse zulässt.

Im Rahmen der untersuchten rund 2 Millionen Beiträge kamen 27 Prozent von Nutzern, die nur einen einzigen Beitrag, ein so genanntes Posting, verfasst hatten. Im Gegensatz dazu zeichneten nur rund 3 Prozent der Nutzer für rund 27 Prozent der Nachrichten verantwortlich. Ein zufällig herausgegriffener Beitrag konnte mit gleicher Wahrscheinlichkeit von einem der 19.000 hochaktiven Beitragenden oder von einem der 580.000 einmaligen Verfassern stammen. Das bedeutet: Ein Meinungsbild einer Gemeinschaft anhand von Beiträgen deuten zu wollen ist gefährlich, weil eine kleine Gruppe quasi die Meinungsführerschaft durch eine Vielzahl von Beiträgen übernimmt, während die „schweigende Masse” der (passiven) User vielleicht gänzlich andere Vorstellungen hat.

Ein anderes besonders deutliches Beispiel des Ungleichgewichts in der Beteiligung an Online-Community-Aktivitäten findet sich im Rezensionssystem von Amazon. Bei mehreren hundertausend Reviews von Lesern gibt es im deutschsprachigen Raum mehrere einzelne Beteiligte, die jeweils mehr als 1.000 Rezensionen geliefert haben (http://ama-zon.de/gp/customer-reviews/top-reviewers.html/). Der Spitzenreiter in den USA (eine ehemalige Büchereiangestellte) hat (zum Zeitpunkt der Recherche dieses Buches) mehr als 13.000 Rezensionen verfasst.

Eine Zahl, die unvorstellbar erscheint, wenn man voraussetzt, dass die Bücher tatsächlich gelesen wurden.

Ebenfalls ein Ungleichgewicht weisen im allgemeinen Wikis, (siehe Glossar) auf. Unter den (zum Zeitpunkt der Recherche) rund 67.000 Autoren bei der Online-Enzyklopädie Wikipedia (siehe: http://en.wiki-pedia.org/wiki/Wikipedia:About), die für rund 4,6 Millionen Beiträge in mehr als 100 Sprachen verantwortlich zeichnen (durch das Prinzip des freien Editierens können auch mehrere Autoren an einem Wikipe-dia-Artikel mitwirken), liefern die 1.000 aktivsten Autoren rund zwei Drittel der Einträge. Setzt man noch die Nutzerzahl von Wikipedia dazu ins Verhältnis (30 Millionen allein für die englischsprachige Ausgabe) dann wird die Dominanz der wenigen bei diesem als Partizipationsmedium gestarteten Projekt extrem.

Abbildung 1: Übersicht der Top-Rezensenten bei Amazon.com

Auch bei anderen Fällen von „User Generated Content”, wie derartige Aktivitäten gerne zusammenfassend genannt werden, also etwa bei Weblogs oder Blogs, gibt es ähnliche Missverhältnisse. Eine Betrachtung und Bewertung, die dieses Ungleichgewicht nicht berücksichtigt, muss daher in die Irre führen. Dies sollten vor allen Dingen Unternehmen in zweierlei Hinsicht berücksichtigen, mit Fokus auf das Intranet – unter Bezug auf die Mitarbeiter des Unternehmens – einerseits und das öffentliche Internet – mit Blick auf die Kunden und deren Meinungsbilder – anderseits.

In beiden Fällen kann es, wie in den geschilderten Beispielen, dazu kommen, dass einzelne Mitarbeiter oder Kunden als Meinungsführer die inhaltliche Diskussion bestimmen und leise Stimmen oder weniger extreme Aussagen dahinter verschwinden bzw. gar nicht erst geäußert werden. Eine einfache statistische Auswertung führt damit naheliegenderweise zu einem verzerrten oder vollkommen falschen Bild dessen, was man eigentlich erzielen möchte.

Aber auch wenn durch diese Feststellung die Wachstumseuphorie bzw. Netzwerkwerteuphorie einen Dämpfer erhält, sind die grundlegenden Auswirkungen auf die Art und Weise, wie wir wirtschaften und miteinander kooperieren, unbestreitbar.

Neuere Betrachtungen des Netzwerkeffektes, wie etwa bei Weiber (Weiber, R: Was ist neu an der New Economy? Die empirischen Gesetze der Netzwerkökonomie. Vortrag Uni Trier, 25.11.2003) sehen den Kern (in Anlehnung an Metcalfes Überlegungen) der Debatte in so genannten „fiktiven Netzwerken”, nämlich bei allen „Gütern, die aufgrund ihres Charakters in einer Vermarktungs- und Nutzungsbeziehung stehen, wodurch sich ein fiktives Netwerk zwischen den Benutzern bildet” und unterscheiden in:

• Direkte Netzwerkeffekte: Der Nutzen eines Gutes steigt dadurch an, dass andere Personen das gleiche Gut einsetzen.

• Indirekte Netzwerkeffekte: Komplementäre Güter (wie Service, Ersatzteile, Zusatzteile, etc.) werden günstiger und sind besser verfügbar aufgrund der steigenden Nutzerzahl des Orginalproduktes.

Und helfen damit in der Praxis weiter als die reine Diskussion, wie genau nun sich der Nutzen mit einem zunehmenden Teilnehmer ver-ändert.

Netzwerkeffekte – wie hier beschrieben – können sowohl im Internet wie auch im Intranet festgestellt werden, d.h. diese sind auch innerhalb der Unternehmensgrenzen nutz- wie beobachtbar.

So setzt etwa das Unternehmen British Telecom (BT) für interne Zwecke ein Wissensmanagementsystem auf Basis eines Wikis ein.

Direkte Netzwerkeffekte – wie eben geschildert – vergrößern den Wert von Wissensdatenbanken und anderen verfügbaren „nichttangiblen” Unternehmensresourcen. Durch die oben benannten indirekten Netzwerkeffekte werden diese Systeme effektiver und besser nutzbar.

1.1.3 Mooresches Gesetz

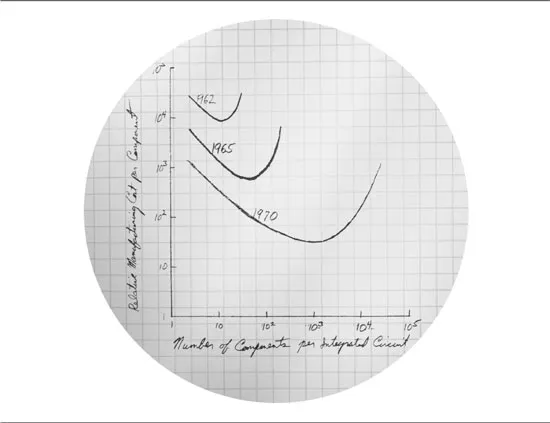

Das so genannte Mooresche Gesetz (oder Moore’s Law) beschreibt den technischen Fortschritt bei integrierten Schaltkreisen. Demnach findet alle 12–18 Monate eine Verdopplung der Komplexität oder Packungsdichte statt. Die Folge ist ein entsprechender Anstieg der Prozessorleistung. Ursprünglich gab Gordon Moore – studierter Chemiker und Mitgründer des Prozessorherstellers Intel – in einem 1965 veröffentlichten Aufsatz in der Zeitschrift Electronics (ftp://download.intel.com/research/silicon/moorespaper.pdf) an, seiner Beobachtung nach wäre von einem 12-Monatszeitraum der Verdopplung der Kapazitäten bei integrierten Schaltkreisen auszugehen. Rund zehn Jahre später korrigierte er den Zeitraum auf 18 Monate. In Fachkreisen wie in der Presse wurde aus dieser Beobachtung sehr schnell das so genannte Mooresche Gesetz.

Abbildung 2: Moores Law Orginalskizze (Quelle: Intel-Archiv)

Tatsächlich haben sich in den letzten Jahrzehnten die Produkte der Halbleiterindustrie in etwa in der von Moore ermittelten Geschwindkeit weiterentwickelt – bei entsprechend sinkenden Kosten –, auch wenn wiederholt Zweifel an der dauerhaften Gültigkeit dieser „Gesetzmäßigkeit” geäußert wurden, war bis dato keine Verlangsamung festzustellen. Jüngste Fortschritte bei der Prozessorproduktion, etwa durch UV-Lithographie und Strained-Silicon-Verfahrenstechnik sowie neuartige Trigate-Transistoren, lassen ein weiteres Wachstum gemäß der Mooreschen Prognose zumindest für die nächsten zehn Jahre erwarten.

Andere Betrachtungen der Entwicklung der Computerindustrie, die etwa die Leistungsentwicklung von Standard-PCs über die Jahre vergleichen, ermitteln ähnliche Innovationszyklen.

Es ist also insgesamt zu erwarten, dass die Rechen- wie Speicherleistung weiterhin stark wachsen und mit dem Anstieg der Übertragungskapazitäten (siehe Gesetz von Gilder) Schritt halten wird.

1.1.4 Gesetz von Gilder

Einen ähnlichen technischen Fortschritt wie in der Halbleiterind...