![]() Strategie und Management

Strategie und Management![]()

1

Strategien für wissensbasierte Produkte und Verfahren

Rudolf W. Kessler

1.1 Übersicht und Abgrenzung

In den 1980er Jahren wurde die Prozessführung vom Messen, Regeln und Steuern bestimmt. Erst in den 1990er Jahren tauchten die Begriffe wissensbasierte Systeme, Expertensysteme, regelbasierte Systeme, Smart Systems, künstliche Intelligenz, maschinelles Lernen, Fuzzy Logik und neuronale Netze auf.

Der Begriff wissensbasierte oder regelbasierte Systeme kommt aus dem Bereich der künstlichen Intelligenz. Wissensbasierte Systeme versuchen, sowohl empirisches Wissen, Know-how, induktiv, als auch Kausalwissen, Logik, deduktiv, in eine mit Computern verständliche Sprache zu integrieren, unabhängig davon wie dieses Wissen zustande kam. Durch das Wissen entsteht eine begründete Information, die in der Lage ist, Ereignisse vorherzusagen.

Diese Vorhersage ist das Kennzeichen von sog. vorwärtsgerichteten, „feed forward = proactive“, Verfahren. Bei den vorwärtsgerichteten Verfahren werden bereits vor dem Eintritt der Störung Maßnahmen ergriffen, weil Planwerte mit den erwarteten Werten nicht übereinstimmen. Um reagieren zu können und zu korrigieren, müssen entsprechende Regeln vorhanden sein, was bei einer vorgegebenen Abweichung zu tun ist. Oft wird deshalb auch von regelbasierten Verfahren gesprochen. Aufgabe der Prozessanalytik ist es, die Informationen für die regelbasierte Produktion bereit zu stellen. Sie gliedert sich in die Wissenserhebung bzw. Erfassung, in die Wissensspeicherung auf Grund von generischem Wissen, Fakten, Regeln und in die Wissensverarbeitung.

Im Gegensatz dazu werden bei den traditionellen rückwärtsgerichteten Verfahren, „feed back = reactive“, die vorhandenen Fehler erst im Nachhinein korrigiert. Hier werden also die realisierten Istwerte mit den Planwerten verglichen.

Der im englischen Sprachgebrauch verwendete Begriff „control“ wird nicht als Kontrolle verstanden, sondern eher als Lenkung. Bei wissensbasierten Systemen existiert eine klare Schnittstelle zwischen anwendungsspezifischem Wissen und der allgemeinen Problemlösungsstrategie. Die Komponente der allgemeinen Problemlösungsstrategie wird Inferenzmaschine, auch computergestützte Schlussfolgerung genannt. Der Vorteil dieses Konzepts ist, dass man eine Problemlösungsstrategie für mehrere Anwendungsgebiete verwenden kann. Es muss nur die entsprechende Wissensbasis ausgetauscht werden [1–3].

Historisch gesehen hat sich die Prozessanalytik aus den Konzepten der Qualitätskontrolle durch Prüfung („Quality by Inspection“) in den 1930er Jahren, der Statistischen Prozesskontrolle („Quality by Statistical Process Control“ (SPC)) in den sechziger und 1970er Jahren und der Prozessregelung durch statistische Versuchsplanung z. B. im Rahmen von SixSigma („Quality through Design“ (Taguchi)) in den 1970er und 1980er Jahren entwickelt [4–6]. Als spezieller Zweig der analytischen Chemie war sie an der Nahtstelle zwischen der Laboranalytik und der Prozesstechnik angesiedelt. Ziel des Quality through Design war es, durch die Qualitätskontrolle nicht nur die Fehler zu beseitigen, sondern durch geeignete Maßnahmen den Prozess so zu gestalten, dass keine Fehler mehr entstehen [7].

Die Prozessanalytik hat insbesondere in den letzten Jahren einen enormen Aufschwung genommen. Grund hierfür ist die Reduktion der Kosten im Bereich der komplexen Messtechnik durch die Mikrosystemtechnik und in der Informationstechnologie, wo immer größere Rechenkapazitäten bei geringeren Kosten zur Verfügung gestellt wurden. Große Popularität erhält die Prozessanalytik auch durch die Vision „Manufuture for 2020“ der Europäischen Kommission und durch die PAT-Plattform („Process Analytical Technology“) der Amerikanischen Food and Drug Administration (FDA) im Jahr 2004 [8, 9]. Hier versucht die FDA zum ersten Mal, die Prozessanalytik als eigenständiges Konzept in den betrieblichen und regulatorischen Ablauf zu integrieren.

PAT wird definiert als „System for Designing, Controlling and Analysing Manufacturing“ und ist im Moment auf die pharmazeutische Industrie beschränkt. Gemeinsam mit dem SixSigma-Konzept und vielen weiteren Empfehlungen u. a. GMP („Good Manufacturing Practice“) wird es Auswirkungen auf die gesamte Fertigungsindustrie auch bei Massenkonsumgütern haben.

Univariate, d. h. eindimensionale, Messgrößen wie z. B. Daten aus der Prozessmesstechnik, z.B. pH, Temperatur etc., können alleine nicht den Vorgang eines Herstellungsprozesses beschreiben. Es sind deshalb multivariate, d.h. mehrdimensionale, und komplexe Informationen wie z. B. in der Prozessanalytik notwendig. Dies kann durch die Verknüpfung einer Vielzahl univariater Messgrößen (z. B. Temperaturarray in einem Röhrenreaktor) geschehen oder durch die Messung einer komplexen, überlagerten Information in Form z. B. eines NIR-Spektrums.

Die Prozessanalytik, auch Prozessanalysentechnik genannt, kann deshalb eine wesentliche Informationsquelle für die Entwicklung von Expertenwissen darstellen, weil sie stoffliche, also chemische und morphologische Information auf molekularer Basis integriert.

Aufgabe der Prozessmesstechnik ist es, Prozesskenngrößen wie Füllstand, Temperatur, Druck etc. zu messen. In der Analysemesstechnik (Prozessanalysenmesstechnik) werden Stoffeigenschaften und Stoffzusammensetzungen meist in Form von Summenparametern bestimmt. In der Fertigungsmesstechnik sollen Geschwindigkeiten, Längen und z. B. Kräfte vermessen werden. Gemeinsames Ziel ist, durch diese Messgrößen den Prozess zu steuern und zu regeln, damit die Qualitätseigenschaften und die Spezifikationen des Produktes eingehalten werden.

Ausgangspunkt der Prozessanalytik ist die Methodik der analytischen Chemie. Die Fragestellungen bei der Entwicklung einer analytischen Methode sind:

- Wie erhalte ich eine repräsentative Probe?

- Wie bereite ich die Proben für die folgende Analyse vor?

- Ist eine Vortrennung der zu analysierenden Substanz und der Matrix notwendig?

- Welche Art der Messung ist am besten geeignet?

- Welche Datenvorverarbeitung und Interpretation ist am besten geeignet?

- Wie stelle ich die Genauigkeit und die Reproduzierbarkeit sicher?

Bei der Prozessanalytik ist das Ziel, diese Funktionen in Realzeit und in einem schwierigen Umfeld mit häufig fachfremdem Personal auszuführen. Die Messung kann dabei kontinuierlich oder intermittierend sein. Dazu ist ein hoher Automatisierungsgrad notwendig und die Geräte müssen außerordentlich robust sein, um sich im industriellen Umfeld zu behaupten. Eine Übersicht und Beschreibung der Methoden ist in [10–13] gegeben.

Als hervorragendes Werkzeug haben sich dabei z. B. die Spektroskopie und die Chromatographie erwiesen. Dabei werden sowohl die chemischen Stoffeigenschaften z. B. über die wellenlängenspezifische Absorption oder Reflexion als auch die morphologischen Eigenschaften z. B. aus den wellenlängenabhängigen Streueigenschaften gleichzeitig erfasst. Beide Kenngrößen bestimmen im Wesentlichen das Eigenschaftsprofil eines Werkstoffes. Allerdings kann diese Information nur überlagert gemessen werden und muss deshalb durch entsprechende multivariate Verfahren, z.B. PCA („Principal Component Analysis“), PLS („Partial Least Square“), kalibriert oder neuerdings auch mit kalibrationsfreien Verfahren wie MCR („Multivariate Curve Resolution“) aus den laufenden Prozessen berechnet werden [14].

Eine mögliche Definition der Prozessanalytik und deren Ziel ist in der Arbeitsrichtlinie des Arbeitskreises Prozessanalytik der Gesellschaft Deutscher Chemiker zu finden:

„Gegenstand der Prozessanalytik sind chemische, physikalische, biologische und mathematische Techniken und Methoden zur zeitnahen Erfassung kritischer Parameter von chemischen, physikalischen, biologischen und Umweltprozessen.“

„Ziel der Prozessanalytik ist die Bereitstellung von relevanten Informationen und Daten für die Prozessoptimierung, -automatisierung, -steuerung und -regelung zur Gewährleistung einer konstanten Produktqualität in sicheren, umweltverträglichen und kostengünstigen Prozessen.“

In der Prozessanalytik werden demnach komplexe Informationen (z. B. Spektren) zeitnah erfasst und mit den modernen Methoden der multivariaten Datenanalyse, Chemometrie oder „Data Mining“, ausgewertet und bewertet. Dies bedingt hohe inter- und transdisziplinäre Arbeitsweisen, weil neben einem Analytiker, Chemometriker/Informatiker, Elektroniker, Verfahrenstechniker etc. auch das Produktionsmanagement und die betriebswirtschaftlichen Rahmenbedingungen mit integriert werden müssen.

Derzeit liegt konzeptionell der Fokus noch stark auf der Prozessoptimierung und der Evaluierung von Sicherheitsrisiken von chemischen Anlagen. Viel weniger wird die Möglichkeit genutzt, das Produkt so zu fertigen, dass es den unterschiedlichen individuellen Kundenprofilen und Erwartungen genau entspricht. Dies wird als Produkteigenschaftsdesign („Product Functionality Design“ oder „Product Property Design“) bezeichnet und wird ausführlich in den nachfolgenden Kapiteln beschrieben. Während bei den Produktinnovationen Technologie und Funktionalität im Vordergrund stehen, verändern sich bei Prozessinnovationen Arbeitsteilung, Prozessführung oder Prozesssteuerung.

Eine optimierte Prozessanalytik versetzt das Unternehmen in die Lage, gleichzeitig den Prozess und das Produkt zu optimieren. Dieses Prozess- und Produkt-Eigenschaftsdesign erlaubt die zielgenaue und kostenminimierte Herstellung unterschiedlichster Produkte. Wenn es computergestützt ist, erlaubt das inverse Modell sogar die Entwicklung neuer Produkte und Verfahren auf dem Computer im Rahmen der definierten Prozessgrenzen. Auch Mehrzieloptimierungen sind schnell, verlässlich und kostengünstig durchzuführen, da die wesentlichen Schritte dazu durch die Modellalgorithmen bekannt sind und wird als „knowledge based process management“ bezeichnet.

1.2 Motivation für wissensbasierte Produkte und Verfahren

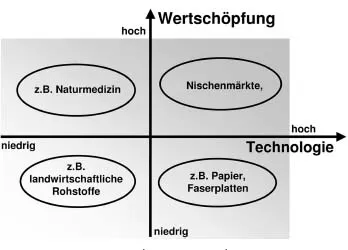

Der Gewinn in der Industrie wird durch die Gestehungskosten (definiert durch die verfügbare Technologie in der Produktion inkl. Zusatzkosten) und durch die Wertschöpfung (definiert durch die Qualität und das Alleinstellungsmerkmal) des erzeugten Produktes bestimmt. Bei verschiedenen Pflanzenextrakten in der Naturheilkunde ist zum Beispiel der technologische Aufwand gering, das Produkt kann jedoch trotzdem zu sehr hohen Preisen verkauft werden, weil sich Angebot und Nachfrage nicht die Waage halten. Bei der Herstellung von Massengütern wie z. B. Papier ist dies umgekehrt. Im vergangenen Jahrzehnt hat die Industrie in den Hochlohnländern eine beispiellose Kraftanstrengung unternommen, einerseits die Produktivität zu erhöhen und zum anderen die Fertigungskosten zum Teil drastisch zu reduzieren. Oftmals wurde dabei auch die Qualität des Produktes erheblich verbessert, konnte aber nicht in eine höhere Wertschöpfung und damit Gewinn umgesetzt werden. Ein Ausweg aus diesem Dilemma wäre eine weitere Rationalisierung der Produktion bei gleichzeitiger Vergrößerung der Kapazitäten. Auf Grund der politischen Rahmenbedingungen (Umwelt etc.) sind jedoch dieser Strategie enge Grenzen gesetzt.

Abbildung 1.1 verdeutlicht das Dilemma, in dem die Industrie steckt. Gezeigt ist hier ein Koordinatensystem, das sich aus der Kostenintensität der Technologie und der Wertschöpfung des erzeugten Produktes bestimmt. In den vergangenen Jahren konnte aber trotz eines gestiegenen Anspruchs an Technologie (= höherer Aufwand) die Wertschöpfung der Produkte nicht gesteigert werden.

Bis jetzt wurde noch kein erfolgreiches und allgemein gültiges Konzept entwikkelt, wie wir dieser Herausforderung begegnen können. Einig ist man sich dabei, dass eine höhere Flexibilität (= Produktvielfalt) und Individualität (= Alleinstellungsmerkmal) in der Produktion und bei den Produkten erforderlich ist, sowie eine in sich konsistente und garantierte Qualität der Produkte. Die Prozessanalytik kann dabei eine Schlüsseltechnologie zur Erreichung dieser Ziele sein.

Wesentliche Vorteile in der Massenfertigung für die Großindustrie erwartet man im Bereich der Produktivität durch die Vergleichmäßigung der Produktion (Reduktion des CV-Wertes „coefficient of variation“, „giveaway“), einer Minimierung der Ressourcen durch kontrollierte Fertigung ohne Sicherheitszuschläge und einem Bonus für zertifizierte und konstante Qualität. Nicht zu unterschätzen ist auch die Möglichkeit des „predictive maintenance“, indem durch eine adäquate Pro...