Maîtrisez l'utilisation des technologies Hadoop

Initiation à l'écosystème Hadoop

- 432 pages

- French

- ePUB (adaptée aux mobiles)

- Disponible sur iOS et Android

À propos de ce livre

Le manuel d'apprentissage de référence

Cet ouvrage est un manuel d'apprentissage technique qui a été rédigé pour toute personne souhaitant développer des compétences sur une ou plusieurs technologie(s) de l'écosystème Hadoop. Il permet d'utiliser de façon professionnelle 18 technologies clés de l'écosystème Hadoop : Spark, Hive, Pig, Impala, ElasticSearch, HBase, Lucene, HAWQ, MapReduce, Mahout, HAMA, Tez, Phoenix, YARN, ZooKeeper, Storm, Oozie et Sqoop.

L'ouvrage permet d'initier les débutants pour les emmener vers une utilisation professionnelle de ces technologies. Pour faciliter la compréhension de l'ouvrage, chaque chapitre s'achève par un rappel des points clés et un guide d'étude qui permettent au lecteur de consolider ses acquis. Des compléments web sont également disponibles en téléchargement sur le site www.editions-eyrolles.com/dl/0067478.

Au fil de la lecture de cet ouvrage, vous allez comprendre les approches conceptuelles de chacune de ces technologies pour rendre vos compétences indépendantes de l'évolution d'Hadoop. Vous serez finalement capable d'identifier les portées fonctionnelle, stratégique et managériale de chacune de ces technologies.

À qui cet ouvrage s'adresse-t-il ?

- Aux consultants BI/big data, data scientists, chargés d'études et chefs de projets data

- Aux étudiants désireux de s'orienter vers le big data

- Plus généralement, à tout professionnel souhaitant prendre le virage du big data ou souhaitant valoriser les données de son entreprise

Foire aux questions

- Essentiel est idéal pour les étudiants et les professionnels qui aiment explorer un large éventail de sujets. Accédez à la bibliothèque Essentiel comprenant plus de 800 000 titres de référence et best-sellers dans les domaines du commerce, du développement personnel et des sciences humaines. Il comprend un temps de lecture illimité et la voix standard de la fonction Écouter.

- Complet est parfait pour les étudiants avancés et les chercheurs qui ont besoin d'un accès complet et illimité. Accédez à plus de 1,4 million de livres sur des centaines de sujets, y compris des titres académiques et spécialisés. L'abonnement Complet comprend également des fonctionnalités avancées telles que la fonction Écouter Premium et l'Assistant de recherche.

Veuillez noter que nous ne pouvons pas prendre en charge les appareils fonctionnant sur iOS 13 et Android 7 ou versions antérieures. En savoir plus sur l'utilisation de l'application.

Informations

PARTIE 1

Les modèles de calcul de l’écosystème Hadoop

1

Les modèles de calcul batch

Principes du traitement parallèle en batch

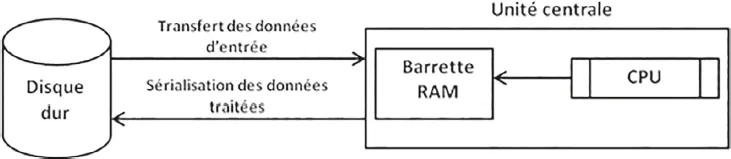

Le traitement sur disque ou batch processing

Table des matières

- Couverture

- Le résumé et la biographie auteur

- Page de titre

- Copyright

- Table des matières

- Avant-propos

- Notes de l’auteur

- Remerciements

- Introduction à l’écosystème Hadoop

- Partie 1 : Les modèles de calcul de l’écosystème Hadoop

- Partie 2 : Les abstractions des modèles de calcul d’Hadoop

- Partie 3 : Le stockage de données en Hadoop

- Partie 4 : La gestion du cluster Hadoop

- Partie 5 : Le streaming en temps réel dans Hadoop

- Partie 6 : Les outils annexes de l’écosystème Hadoop

- Partie 7 : Adoption à grande échelle d’Hadoop

- Conclusion générale de l’ouvrage

- Votre avis compte !

- Liens et références utiles

- Index